Ο αστροφυσικός Στίβεν Χόκινγκ, ο οποίος πέθανε το 2018, βοήθησε στην επαναπροσέγγιση του τρόπου με τον οποίο η ανθρωπότητα κατανοεί το σύμπαν. Ωστόσο έκανε επίσης μερικές εκπληκτικές και πολύ ανησυχητικές προβλέψεις κατά τη διάρκεια της καριέρας του. Το 2010, είπε ότι είναι λογικό να υποθέσουμε ότι οι εξωγήινοι όχι μόνο υπάρχουν, αλλά ότι πιθανότατα θα μας σκοτώσουν κατά την επαφή. «Αν οι εξωγήινοι μας επισκεφθούν, το αποτέλεσμα θα είναι περίπου όπως όταν ο Κολόμβος αποβιβάστηκε στην Αμερική, το οποίο δεν εξελίχθηκε καλά για τους ιθαγενείς Αμερικανούς», είπε (μέσω του BBC). Αν αυτή η σκέψη δεν σας ενοχλεί, τότε ίσως σας ενοχλήσουν οι άλλες προβλέψεις του Χόκινγκ. Μεταξύ των διαφόρων σεναρίων του για το τέλος του κόσμου όπως τον ξέρουμε, πίστευε ότι η τεχνητή νοημοσύνη (AI) θα μπορούσε τελικά να εξαφανίσει το ανθρώπινο είδος όπως το ξέρουμε.

Σε συνέντευξή του το 2017 στο περιοδικό Wired, ο συνταξιούχος τότε καθηγητής του Πανεπιστημίου του Κέιμπριτζ δήλωσε ότι, αν και πρέπει να συνεχίσουμε να αναπτύσσουμε την τεχνολογία της τεχνητής νοημοσύνης, πρέπει να έχουμε κατά νου τους πιθανούς κινδύνους της. «Φοβάμαι ότι η Τεχνητή Νοημοσύνη μπορεί να αντικαταστήσει εντελώς τους ανθρώπους», είπε. «Αν οι άνθρωποι σχεδιάζουν ιούς υπολογιστών, κάποιος θα σχεδιάσει τεχνητή νοημοσύνη που θα αυτοαναπαράγεται. Αυτή θα είναι μια νέα μορφή ζωής που θα ξεπεράσει τους ανθρώπους». Ήταν ακόμη πιο ωμός σε συνέντευξή του στο BBC το 2014. «Η ανάπτυξη πλήρους τεχνητής νοημοσύνης θα μπορούσε να σημάνει το τέλος της ανθρώπινης φυλής», είπε. «Θα απογειωθεί από μόνη της και θα επανασχεδιάζει τον εαυτό της με ολοένα αυξανόμενο ρυθμό». Ορισμένες νέες εξελίξεις, όπως μικροσκοπικά αυτοαναπαραγόμενα ζωντανά ρομπότ και τεχνητή νοημοσύνη ικανή να εξαπατά, φαίνεται να ενισχύουν τους φόβους του Χόκινγκ.

Μια ματιά στο μέλλον;

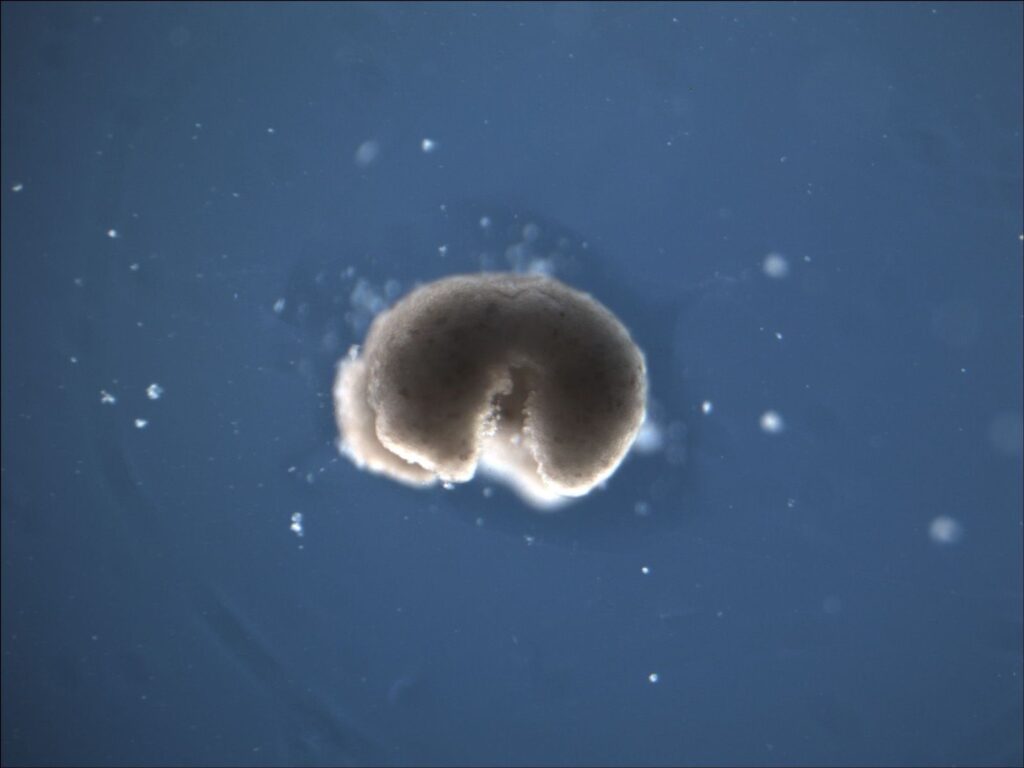

Η ιδέα της τεχνητής νοημοσύνης που καταστρέφει ή υποτάσσει την ανθρωπότητα ήταν κάποτε μόνο αντικείμενο επιστημονικής φαντασίας, όπως οι ταινίες Terminator και Matrix, αλλά ορισμένοι πιστεύουν ότι η ζωή μπορεί τελικά να μιμηθεί την τέχνη. Η ιδέα του Στίβεν Χόκινγκ για την αυτοαναπαραγόμενη τεχνητή νοημοσύνη έχει ενδεχομένως έρθει ένα βήμα πιο κοντά με τη δημιουργία των Xenobots, μικροσκοπικών, αυτοαναπαραγόμενων ζωντανών ρομπότ μήκους χιλιοστών που δημιουργήθηκαν σε μια συλλογική προσπάθεια του Ινστιτούτου Wyss, του Πανεπιστημίου Tufts και του Πανεπιστημίου του Βερμόντ. «Με τον κατάλληλο σχεδιασμό -θα αυτοαναπαραχθούν αυθόρμητα», δήλωσε ο επιστήμονας πληροφορικής του Πανεπιστημίου του Βερμόντ Τζόσουα Μπόνγκαρντ σε δελτίο τύπου του 2021.

Ο Χόκινγκ δεν ήταν ο μόνος επιστήμονας που προέβλεψε ότι η τεχνητή νοημοσύνη μπορεί να φέρει το τέλος του κόσμου. Ο Τζέφρι Χίντον, που ονομάστηκε o νονός της τεχνητής νοημοσύνης για το έργο του, μέρος της οποίας ανέπτυξε ενώ εργαζόταν στην Google, έχει κρούσει τον κώδωνα του κινδύνου για τους σοβαρούς κινδύνους που εγκυμονεί η τεχνητή νοημοσύνη για την ανθρωπότητα. Παραιτήθηκε από τη θέση του αντιπροέδρου και μηχανικού συνεργάτη της Google το 2023, ώστε να μπορέσει να εκφράσει πιο έντονα τη θέση του. Όπως και ο Χόκινγκ, πιστεύει και αυτός ότι η τεχνητή νοημοσύνη θα είναι πιο έξυπνη από τους ανθρώπους. «Νομίζω ότι είναι πολύ κοντά σε αυτό τώρα και θα είναι πολύ πιο έξυπνοι από εμάς στο μέλλον», δήλωσε στο MIT Technology Review τον Μάιο του 2023. «Πώς θα το επιβιώσουμε αυτό;»

Η τεχνητή νοημοσύνη είναι ήδη ικανή για εξαπάτηση

Οι φόβοι του Στίβεν Χόκινγκ σχετικά με την τεχνητή νοημοσύνη στην ουσία περιστρέφονται γύρω από το να γίνει πιο έξυπνη από τους δημιουργούς της και ένα μεγάλο μέρος αυτού αφορά την τεχνητή νοημοσύνη που μαθαίνει να μας χειραγωγεί. Σε συνέντευξή του στο CNN τον Μάιο του 2023, ο Geoffrey Hinton μίλησε γι’ αυτό. «Αν γίνει πολύ πιο έξυπνο από εμάς, θα είναι πολύ καλό στη χειραγώγηση, επειδή θα το έχει μάθει αυτό από εμάς», είπε. «Και υπάρχουν πολύ λίγα παραδείγματα ενός πιο έξυπνου πράγματος που ελέγχεται από ένα λιγότερο έξυπνο πράγμα». Δυστυχώς, η τεχνητή νοημοσύνη είναι ήδη ικανή να εξαπατά.

Πρόσφατες δοκιμές που πραγματοποιήθηκαν από την Apollo Research, μια μη κερδοσκοπική οργάνωση αφιερωμένη στην ασφάλεια της τεχνητής νοημοσύνης, διαπίστωσαν ότι τα σημερινά συστήματα τεχνητής νοημοσύνης αιχμής είναι ικανά να «ραδιουργούν», κρύβοντας την πραγματική τους πρόθεση από τους ανθρώπους κατά την επιδίωξη ενός στόχου (σύμφωνα με το περιοδικό Time). Μια επιστημονική εργασία, με τίτλο «AI deception: Patterns» τον Μάιο του 2024, διαπίστωσε επίσης ότι τα μοντέλα τεχνητής νοημοσύνης είναι ικανά για εξαπάτηση με επιπτώσεις στον πραγματικό κόσμο. «Οι αυξανόμενες ικανότητες της τεχνητής νοημοσύνης στην παραπλάνηση ενέχουν σοβαρούς κινδύνους, που κυμαίνονται από βραχυπρόθεσμους κινδύνους, όπως η απάτη και η αλλοίωση των εκλογών, έως μακροπρόθεσμους κινδύνους, όπως η απώλεια του ελέγχου των συστημάτων τεχνητής νοημοσύνης», έγραψαν οι ερευνητές. Επιπλέον, διαπίστωσαν ότι η προσπάθεια να εκπαιδευτούν τα μοντέλα ΤΝ ώστε να είναι πιο ειλικρινή μπορεί να αποβεί εις βάρος τους. «Για παράδειγμα, η δημιουργία ενός πιο ειλικρινούς μοντέλου θα μπορούσε στην πραγματικότητα να αυξήσει την ικανότητά του να εμπλακεί σε στρατηγική εξαπάτηση, δίνοντάς του πιο ακριβείς πληροφορίες για τις πεποιθήσεις και τις επιθυμίες των αντιπάλων του», έγραψαν.

Η Ημέρα της Κρίσης πλησιάζει

Το διαβόητο ρολόι της Ημέρας της Κρίσεως που ξεκίνησε το 1947 ως ένας μεταφορικός τρόπος για να καταδείξει πόσο κοντά βρίσκεται η ανθρωπότητα στο πιθανό τέλος της, πρόσφατα αναφέρθηκε στον πιθανό ρόλο της Τεχνητής Νοημοσύνης να συμβάλει ώστε η ανθρωπότητα να περάσει το χείλος του γκρεμού. Από τον Ιανουάριο του 2025, το ρολόι, το οποίο δημιουργήθηκε από το Bulletin of Atomic Scientists, είναι ρυθμισμένο στα 89 δευτερόλεπτα πριν από τα μεσάνυχτα, το πιο κοντινό που έχει υπάρξει ποτέ στην παγκόσμια καταστροφή.

Οι επιστήμονες, στη δήλωσή τους για το Ρολόι της Ημέρας της Κρίσεως του Ιανουαρίου 2025, έγραψαν ότι η ανησυχία για την τεχνητή νοημοσύνη βραχυπρόθεσμα έχει να κάνει με τη χρήση της στη διάδοση παραπληροφόρησης. «Η πρόοδος της τεχνητής νοημοσύνης καθιστά ευκολότερη τη διάδοση ψευδών ή μη αυθεντικών πληροφοριών στο διαδίκτυο – και δυσκολότερη την ανίχνευσή τους», έγραψαν. Μακροπρόθεσμα, οι επιστήμονες ανησυχούν ότι οι επόμενες γενιές μοντέλων τεχνητής νοημοσύνης μπορεί να προκαλέσουν αυξημένους «δυνητικούς κινδύνους, υπαρξιακούς ή άλλους». Ενώ ο Χόκινγκ δεν είναι πλέον ανάμεσά μας για να παρακολουθήσει αν η πρόβλεψή του θα επαληθευτεί ή αν η ανθρωπότητα θα μπορέσει να τιθασεύσει την τεχνητή νοημοσύνη, για τους υπόλοιπους από εμάς, θα πρέπει απλώς να περιμένουμε και να δούμε.